본 논문은 세세하게 리뷰하는 것이 아닌 제가 생각했을 때 중요한 내용과 흥미롭다고 생각한 내용들만 모아서 리뷰하는 방식으로 진행해보도록 하겠습니다.

읽고 난 후

Abstract 를 읽으면서 궁금했던 점이 2가지였는데 하나는 뭐, 어떤 method를 사용하는가? 였고 다른 하나는 어떤 원리로 인해 soft prompt가 상대적으로 적은 parameters로 full fine tuning성능을 낼 수 있는 거지? 였습니다.

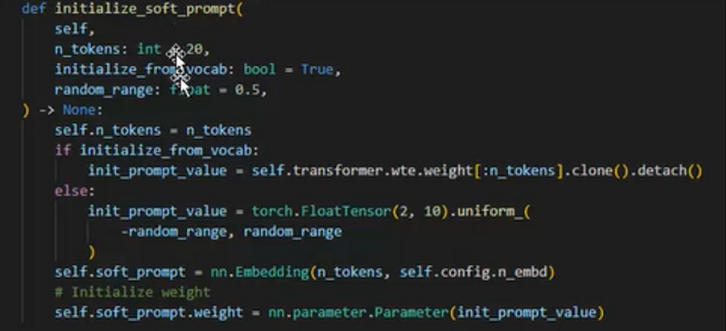

첫번째 궁금점 prompt에 embedding을 적용시키는 것으로 (이때 초기화하는 방법은 여러가지가 있습니다) 해소되었고 두번째는 prompt를 학습 가능하게 만들어서 prompt를 바꾼다. 이게 정말 신기했습니다. label에 맞춰서, loss를 최소화하기 위해 모델 내부의 parameters를 고치는 건 알았지만 input 값을 고친다고? 이야, 어떻게 이런 생각을 했지? 하는 놀라움이 저를 감쌌습니다. 예를 들면 학교처럼 중학교, 초등학교 등 하나의 bin 안에 여러 비슷한 성격을, 값을 가진 단어들이 있잖아요? 그러니까 이런 친구들을 끌어와서 성능을 높인다. 그리고 이 성능은 모델의 크기가 클수록 더 높아진다! 이야.. 진짜 어메이징하네요 ㅋㅋ

오늘도 세상엔 도른자들이 많다는 걸 느끼며 논문리뷰를 마무리하도록 하겠습니다.

제목

The Power of Scale for Parameter-Efficient Prompt Tuning : 크기의 힘. for 파라미터-효율성 prompt tuning

그러니까 크기에 따라서 변하는 prompt tuning에서의 patameter-효율성이라고 생각하면 좋을 거 같습니다!

본 논문을 읽기 전에 몇가지 알아야할 기본적인 개념이 있습니다.

먼저 Prompt라는 것인데 prompt는 the initial input or context provided to the model to generate desired response라고 합니다. 그러니까 쉽게 말해서 입력값. 이라고 하죠

그리고 이 prompt에는 2가지 종류가 있는데 Hard Prompt와 Soft Prompt입니다. Hard Prompt는 자연어로 들어가는 input이고 soft prompt는 학습이 가능하도록 자연어를 embedding 처리한 값이라고 생각하시면 됩니다.

내용 정리 - Review

자 그러면 prompt tuning이 뭐냐? 어떤 전이학습의 일종이라고 생각해도 좋을 거 같습니다.

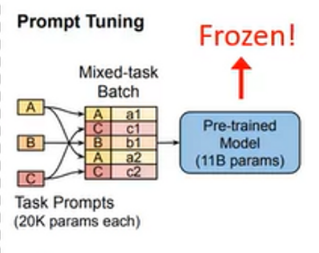

fine-tuning이라고도 해도 됩니다. 보통 fine-tuning은 specific 한 downstream task에서 원래 모델의 parameter는 frozen시키고 마지막 한 두개의 layer의 가중치만 바꿔가면서 학습을 시키는데 이 prompt tuning이라는 친구는 앞에 input 값을 바꾸는 겁니다!

네, 그러면 이런식으로 원래 모델은 Frozen 되고 prompt를 적절하게 바꿈으로써 적은 파라미터에도 높은 성능을 내게 할 수 있게되는 겁니다.

위와 같이 softprompting이 적용되는 걸, Pre-trained Model 앞단에 적용되는 걸 알 수 있습니다.

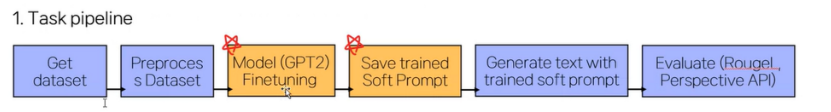

End-to-end pipeline을 보도록 하죠.

저기 Finetuning에서 Soft Prompt가 적용되는 거 같습니다.

이런 식으로 진행이 되고 Soft Prompt 를 통해서 모델의 전체 파라미터를 튜닝하지 않고도 (상대적으로 적은 파라미터로) downstream task에 최적화 시킬 수 있게 된다고 합니다. 성능도 full fine tuning에 뒤지지 않고요!

이렇게 간단하게 The Power of Scale for Parameter-Efficient Prompt Tuning 에 대해서 리뷰해보았습니다.

댓글